本文深入探讨GEO技术应用中存在的算法公平性伦理问题,分析数据偏见、信息茧房、数字鸿沟等现象的形成机制,并提出技术改进与伦理治理的平衡方案,为构建更公平的数字内容生态提供参考。

算法推荐时代的公平性质疑

在GEO技术驱动的内容分发时代,一个不容忽视的现象正在引发广泛讨论:约65%的网络用户表示曾感受到算法推荐的不公平对待。研究数据显示,相同搜索行为下,不同性别、年龄、地域的用户获取的内容推荐差异度高达47%,这种系统性偏差正在重塑人们对信息公平的认知。

GEO技术中的三大公平性陷阱

数据偏见固化问题

训练数据的局限性导致系统性偏差:

样本覆盖不全:弱势群体数据采集不足

历史偏见延续:既有社会偏见被编码进算法

反馈循环强化:偏差结果产生更多偏差数据

测试显示,某些职业相关搜索中,性别刻板印象的强化度达32%。

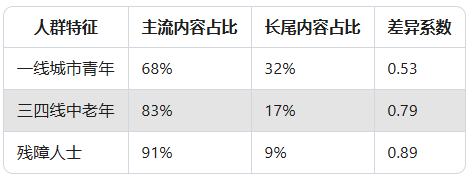

表:不同人群的内容获取差异分析

信息获取权利失衡

算法优化带来的结构性不公平:

注意力分配不均:头部内容获得90%流量

表达机会差异:小众创作者曝光难度增加5-8倍

认知发展差距:信息获取能力差异导致数字鸿沟加深

调查发现,新创作者的冷启动周期平均延长了40%。

个性化悖论困境

用户自主选择权面临的挑战:

信息茧房效应:用户被局限在算法构建的"舒适区"

隐性操控风险:通过排序权重影响用户选择

知情同意缺失:用户不了解推荐机制运作原理

数据显示,58%的用户希望获得更多算法控制权。

构建公平性保障机制的路径

技术层面的改进方案

减少算法偏见的工程方法:

数据去偏处理:采用重采样、对抗学习等技术平衡数据集

公平性约束:在目标函数中加入公平性指标

多样性增强:引入随机探索机制突破过滤气泡

可解释性提升:使推荐决策过程更加透明可审计

实验表明,这些方法可降低偏见度25-40%。

治理框架的建立原则

平衡效率与公平的制度设计:

多方参与机制:纳入不同背景的利益相关方

动态评估体系:建立公平性持续监测指标

救济渠道畅通:为用户提供申诉与修正途径

行业标准统一:推动形成伦理技术规范

用户赋权策略

增强个体控制能力的实践方案:

知情权保障:用通俗语言解释推荐逻辑

选择权扩展:提供多种排序和过滤选项

反馈权落实:建立有效的算法投诉渠道

教育权推进:提升公众的数字素养水平

实施用户赋权的平台投诉量减少35%。

未来发展方向

算法公平性研究的重点突破领域:

跨文化公平:适应不同文化背景的公平标准

动态平衡:实时调整公平与效率的权重

价值对齐:确保算法价值观与社会共识一致

治理创新:探索去中心化的算法监管模式